Nº 2674 - Novembro de 2024

Pessoa coletiva com estatuto de utilidade pública

O termo risco tem uma origem indefinida, mas parece remontar ao século XVI. A sua relevância é especificamente moderna, sendo sintomático que nem em Grego nem em Latim pareça haver um termo sinónimo (o que é pouco frequente em conceitos das línguas modernas do Ocidente). Se apenas no final do século XX, associado ao termo «sociedade de risco», o conceito ganhou notoriedade pública (mediática), quando já existia há décadas uma autêntica indústria do Risco (como veremos a propósito das declinações empíricas do termo), cumpre reconhecer que o Risco é conatural à modernidade (no sentido dominante, Ocidental, do termo). É dessa ligação entre Risco e economia moderna que advém (desde o século XX) a relevância ainda subapreciada do «risco subjectivo», usualmente designado Incerteza, que assume neste artigo um papel central na argumentação, pela sua pertinência na questão da Inteligência Artificial.

Enquanto conceito operativo, Risco adquiriu relevância com o desenvolvimento da economia moderna, crescentemente dependente de seguros em função dos perigos inerentes ao crescente movimento de bens, pessoas e capitais a partir da expansão marítima de sucessivas potências europeias. O Risco é uma questão técnica, quantificável, em que probabilidades, conhecidas com grau variante de definição através de séries estatísticas, servem de instrumento para a indústria seguradora desenvolver a sua actividade. Com os riscos específicos consolidados é possível aplicar a lei dos grandes números para os medir e compartimentar, associando a cada risco um determinado valor (prémio) específico1. A relevância desta prática até aos nossos dias viu-se já no século XXI com a crise global de 2007-2009, em grande medida causada pelos produtos (CDO, CDO-squared) engendrados por uma indústria financeira, na qual a falta de regulação efectiva levou a uma distorção do padrão de risco através da criação e comercialização desses produtos compósitos2, nos quais se misturavam várias (e divergentes) classes de risco, subvertendo assim o propósito de contenção e gestão do risco próprio da prática atuarial.

Este ponto é importante considerar. O tema do «moral hazard» (risco moral, aliás uma tradução imperfeita) foi muito explorado na altura, e até hoje, mas a tese de um conhecimento assimétrico que leva a comportamento diferenciado por uma arte de um contrato ter mais conhecimento do que a outra incorre em limitações materiais e metodológicas relevantes. Isso não significa que tais casos não existam, apenas que em casos de dimensão como a da crise de 2007-2009 o que se verifica é que mesmo a parte que julga deter mais conhecimento é surpreendida pelo carácter ilusório dos seus dados3. O hazard não se revelou apenas moral; foi um hazard existencial («ontológico», para quem aprecie linguagem filosófica). Neste ponto, para traduzir hazard afigura-se-nos mais indicado falar de incerteza, moral ou existencial, do que de risco. Pelo menos nos casos «macro» (económicos, ambientais, sanitários, securitários), em que não estão em causa transações bem delimitadas mas processos económico-legais amplos, o factor problemático não é a mera assimetria entre as partes do processo, mas sim a indeterminação da situação no seu conjunto. Fórmulas como as de «avaliação de risco sistémico» são reconhecidamente vagas e de fraco valor preditivo, sendo sobretudo instrumentos de incentivo à diversificação de portfolios de investimento. Mesmo a posteriori, o conhecimento que proporcionam não faz justiça à complexidade dos eventos. Em suma, não limitam o risco nem permitem conhecer melhor casos ocorridos para mitigar efeitos de ocorrências desses riscos.

Que a proliferação do termo risco prossiga sem sobressaltos de crise em crise (da financeira para a da covid19, por exemplo), quando as suas limitações se tornam cada vez mais patentes e as suas consequências mais graves e difíceis de ultrapassar, deveria bastar para que entidades reguladoras, agentes económicos, decisores políticos prestassem atenção com um novo olhar ao recurso a este mecanismo específico de enquadramento da actividade económica (no sentido mais amplo, social, do termo). Contudo, e como o caso da Inteligência Artificial (IA) irá exemplificar, não é isso que se verifica. Pelo contrário, o discurso de «Risco como técnica» é pervasivo em todas as áreas, desde a Finança à Saúde, da Tecnologia à Defesa, indiferente aos resultados limitados ou extremamente nocivos (por falhanço preditivo de crises) que exibe.

A valorização do conceito de incerteza, tanto no domínio da elaboração de políticas por parte dos poderes públicos como pela parte da organização da actividade por agentes económicos, quer ainda pela parte de entidades reguladoras, não visa substituir o conceito de Risco, cuja aplicabilidade e relevância persiste e continuará a ser no futuro previsível da maior relevância naqueles casos em que a disponibilidade de séries estatísticas é real. A valorização do conceito de Incerteza justifica-se complementarmente, isto é, naqueles casos em que tais dados não estejam disponíveis – por virtude de questão ser nova ou apenas insuficientemente conhecida – e em que a sua relevância não seja negligenciável. Ou seja, a Incerteza tal como aqui entendemos (no seguimento de literatura especializada pelo menos desde 1921) define-se como:

– subcampo de Risco (complementar, não adversarial, de avaliações de Risco);

– de natureza existencial/ontológica, não apenas moral ou cognitiva;

– operacional em contextos de inaplicabilidade técnica de avaliações de Risco.

Neste domínio conceptual, e seguindo a lição de Hermínio Martins (Martins, 2011), o ano de 1921 é data a reter: a publicação simultânea de A Treatise on Probability (J. M. Keynes) e de Risk, Uncertainty and Profit (F. H. Knight) assinala a densificação dos conceitos, com Risco e o seu correlato Incerteza a adquirirem relevância: quando as probabilidades não podem ser quantificadas, a indústria seguradora deixa de poder proporcionar o modelo para definir e gerir riscos, restando assim a «estimativa», conceptualizada em «intervalos», dentro dos quais podemos identificar (não determinar) probabilidades maiores ou menores. O ponto reside na disponibilidade ou não de dados suficientes para conhecer o problema – sem o domínio dos seus termos não é possível quantificar, mensurar, gerir o risco; e este devém incerteza (no limite, pode ser ainda acrescentada a Ignorância, colocando-se então a questão de saber se pode ou não haver uma ignorância radical, plena; mas esse é um problema filosófico, adjacente mas não pertencente ao conceito de Risco).

Não obstante estes pergaminhos ilustres e alguns momentos de interesse pelo conceito de Incerteza (como «A era da Incerteza» na década de 1970, por J. K. Galbraith) foi a linguagem e a mentalidade de Risco que triunfou hegemonicamente. Isso será evidente quando considerarmos a experiência histórica, mas também no plano conceptual é patente: o conceito de risco suplantou todas as linguagens alternativas e confunde-se com a própria autoimagem das sociedades contemporâneas, nomeadamente na fórmula «sociedade de risco», cunhada já há décadas pelo sociólogo alemão Ulrich Beck (Risikogesellschaft). O modo como a sociedade actual responde ao risco, no caso de estudo de Beck com um foco particular na questão ambiental, é a característica capital na análise social. De um modo geral, o bem procurado na vida social (a produção de bens, de riqueza, inacessível ao indivíduo de modo isolado) é acompanhado de produção de males (v.g., poluição), tornando-se, portanto, o Risco no conceito capital para mediar este processo, tornando-o quer inteligível quer operativo. Apesar de a lógica da riqueza ser positiva (criação, distribuição) e a do risco ser negativa (preservação, segurança), esta tende a predominar4.

Ainda a nível conceptual, note-se como a linguagem do risco não é progressista, como era próprio do discurso iluminista, mas regressiva (muito pensamento ecológico tem esta marca de anti-modernidade precisamente pelo seu foco nos perigos associados à modernização tecnológica, riscos no sentido etimológico do termo, perigo de dano). Contudo, a regressividade nunca contesta a própria conceptualização: mesmo perante casos extremos (crises climáticas, de âmbito não delimitável), a categoria risco mantém a primazia apesar de ser inegável a limitação do nosso conhecimento e a falta de muitos dados necessários para se poder levar a cabo uma efectiva análise de risco. Este apego ao conceito de risco denota um preconceito intelectual: ao contrário de Knight, Keynes e outros (poucos) pensadores que viram na Incerteza e no próprio Risco algo de incontrolável e intrínseco ao mundo da vida (social e também natural), a maioria dos autores, em linha com a maioria dos decisores e a maioria do público, opta por reduzir esta dimensão ontológica dos conceitos a um problema meramente epistémico, passível de resolução através de aumento da capacidade de processamento de dados. Reencontramos nisto os resquícios de uma modernidade iluminista, crente na cumulatividade do conhecimento e na bondade intrínseca do seu crescimento, mas aqui (tal como no século XVIII) desprovida de capacidade de auto-exame5. Tanto na teoria como na experiência histórica, nada oferece fundamento sólido à pretensão de se poder operar uma deflação da incerteza (Martins, 2011: 197) através da perfectibilidade infinita da análise de risco (para uma discussão desta questão no pensamento económico, cf. idem, 197-202).

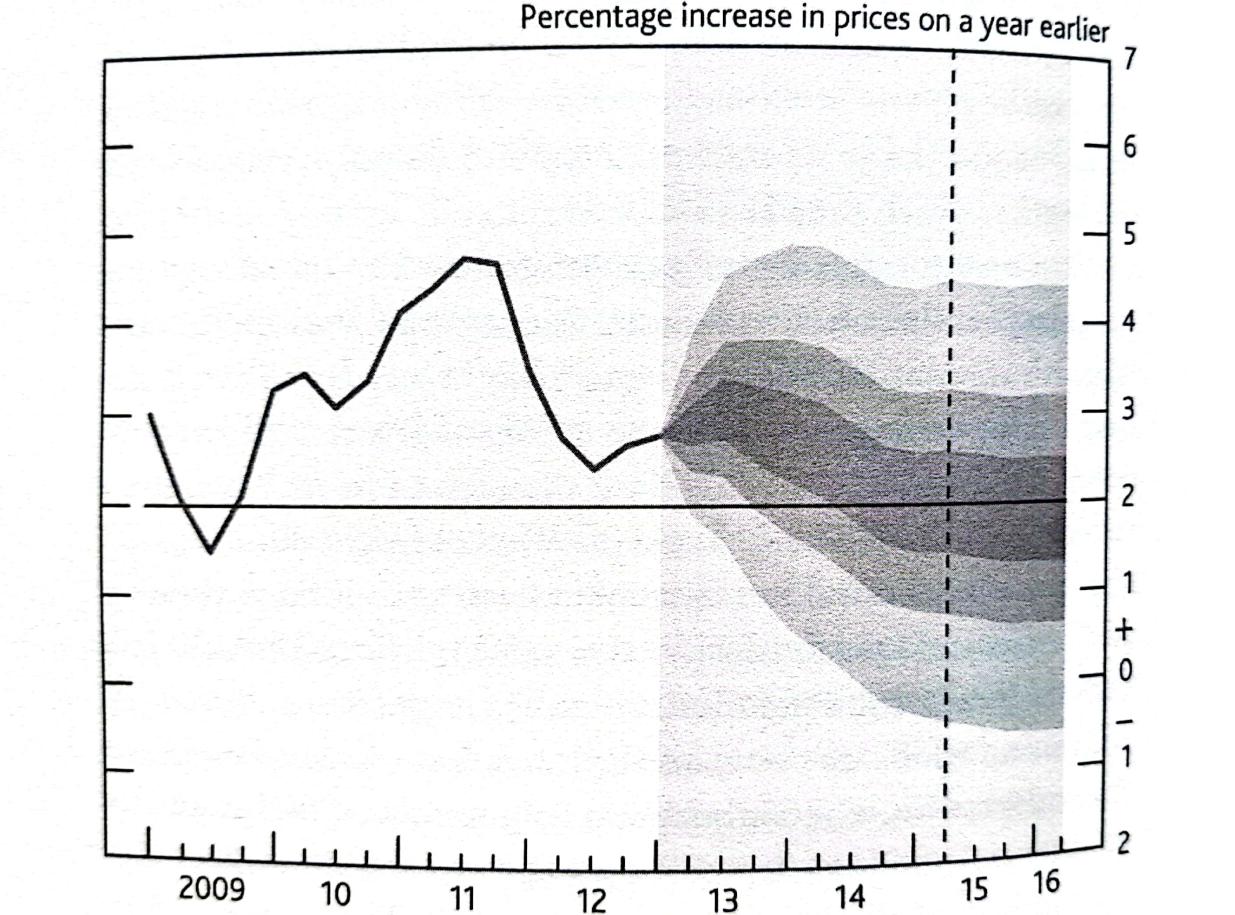

E para não nos reportarmos apenas ao pensamento económico, mas também à sua prática, a um nível tão elevado como o da Administração do Banco de Inglaterra, merece nota o facto de já há mais de uma década que esta instituição central na economia mundial incorpora análise de Incerteza nos seus trabalhos. Vale a pena citar mais extensamente6:

«(…) a central bank must convey inescapable uncertainty to people who crave unavaible certainty. The Bank of England was the first central bank to employ a visual method to display its judgement about the degree of uncertainty surrounding the impacts of its decisions on its targets – the annual inflation rate of consumer prices. (…) For a given level of interest rates, the uncertainty about the result of inflation was displayed in a ‘fan chart’ – the figure below depicts this chart from the Bank of England’s Inflation Report of May 2013.» (p. 103).

«The aim of the fan chart was to shift attention away from point forecasts (‘next year’s inflation will be 2,3%’) which had dominated macroeconomics forecasting and to introduce a narrative of uncertainty. During the financial crisis the fan was widened to communicate greater uncertainty even though there was no basis for quantifying precisely by how much. Quite deliberately, the fan charts did not contain a line for central forecast – the aim was for the reader to come away with a visual impression of the degree of uncertainty. (…) Provided fan charts are interpreted as a way of telling a story through a picture rather than a statement of numerical probabilities, they form a useful way of communicating uncertainty (as it is perceived by central banks) to a wider audience.» (Key and King 2020: 105)

Contudo, o conceito de Risco continua a assumir hoje uma relevância técnica e comunicacional maior do que alguma vez na sua História, sendo provável que assim continue no futuro (apesar de casos como o do banco central referenciado acima).

Considere-se o uso técnico-profissional do termo: análise de risco, gestão de risco, risco moral (economia), etc. O risco como ferramenta de gestão especializada, enquanto indústria integrada no sector dos serviços, mas com aplicações políticas (risco reputacional), ou ainda energética (análises de risco de impacto ambiental, p. ex.) é uma realidade em crescendo desde a Guerra Fria que nunca cessou de se desenvolver. As «análises custo-benefício», as «análises probabilísticas de risco», as «análises de risco tecnológico», etc., são normas aceites tecnicamente e politicamente, apesar de deficiências patentes (distribuição de riscos, temporalidade dos riscos) já notadas por diversos autores (Martins para um sumário crítico, Sakai, 2019, para um foco no uso de energia nuclear).

O risco imiscui-se também, em parte, no significado de em termos de cariz psicológico (como «ansiedade») e é empregue em numerosas análises do comportamento de cidadãos (por norma, em estudos sobre sociedades ocidentais). Termos como «ansiedade de estatuto», resiliência (robustez, em alguns casos), entre outros, comportam esta dimensão de risco (de novo, a incerteza é menosprezada). Instâncias de Risco (naturalmente, por via das seguradoras) ocorrem ainda na Medicina, em «consentimento informado» (em intervenções cirúrgicas) e em «risco partilhado» (no uso drogas experimentais), termos em que a Incerteza dos pacientes (e por vezes dos praticantes) sobre o que está em causa talvez devesse ser mesmo considerada como ignorância.

Nos últimos anos, multiplicam-se menções a de-risking, um termo cuja natureza meramente negativa indica já impasses quanto à pertinência do uso irrestrito de análises de risco. Nesta acepção, o risco é objecto de des-investimento, ou seja, não se revê o conceito, mas condiciona-se a exposição do agente a riscos pela limitação das suas instâncias. O de-risking é então uma tentativa de controlar a roda da fortuna de Maquiavel, empregue sobretudo no sector financeiro, seja por questões de reputação, regulamentação ou simples lucratividade. Não altera em nada substancial o conceito e a prática consagrada do seu emprego.

Este é o contexto no qual a IA enquanto tema autónomo se desenvolve e cuja dinâmica vai influenciar. Nele, o discurso do Risco continua a predominar, sem que isso diminua – pelo contrário – a multiplicação de casos de Incerteza.

As instâncias de incerteza actualmente denominadas (quase sempre) como Risco, nomeadamente as de natureza tecnológica, são múltiplas. O debate crescente sobre IA, no qual o vocabulário do Risco persiste apesar de ser claro que o grau de desconhecimento de múltiplas variáveis recomendaria falar-se de Incerteza, é o que aqui mais nos importa apesar de ser apenas um caso entre muitos possíveis. A crescente dependência das actividades económicas, sobretudo as de maior valor-acrescentado, da integração de tecnologia torna esta tendência duradoura e, tanto quanto se pode prever, cada vez mais predominante no futuro. Com efeito, o sucesso da linguagem do Risco na economia e na vida quotidiana advém em grande medida do seu carácter instrumental, em que se torna parte daquilo que analisa, integrando a cadeia de valor de produtos e decisões das mais diversas esferas de actividade. Este carácter bifronte do Risco, que em vez de se manter distanciado dos seus objectos de análise configura uma espécie aparentemente neutra de «observação participante», que densifica a descrição dos seus objectos de análise conferindo-lhes maior valor, é a nosso ver o elemento central da ubiquidade do conceito e do seu interesse comercial (em qualquer sector de actividade). Já as estimativas de Incerteza, pelo seu carácter admitidamente aproximativo e não quantificado, não são integráveis na economia de serviços com ductilidade comparável, permanecendo num plano usualmente denominado teórico (termo usado com carácter quase sempre pejorativo), o qual encerra, contudo, usos potenciais nos processos de tomada de decisão mais complexos e sensíveis: político, regulatório e em processos económicos vastos e sofisticados.

A diferença mencionada é detectável no contínuo de revoluções industriais da Modernidade. Enquanto as duas primeiras revoluções decorrem num paradigma de intervenção do homem sobre a natureza a partir de um lugar diferenciado, no qual interfere quer com a produção quer com a organização da produção de bens mantendo-se diferenciado e senhor dos procedimentos, na terceira revolução e na quarta revoluções é já dentro do mundo da tecnologia e na interação entre os artefactos desta que decorre a inovação económica7. É predominantemente na complexidade, inovação e disrupção causadas pelos avanços tecnológicos destas duas últimas fases que se assiste à multiplicação de casos em que a linguagem e as práticas ligadas ao Risco se revelam falhas ou mesmo ilusórias, e que o recurso a estimativas não quantificadas como as elaboradas no quadro de Incerteza se revela pertinente8.

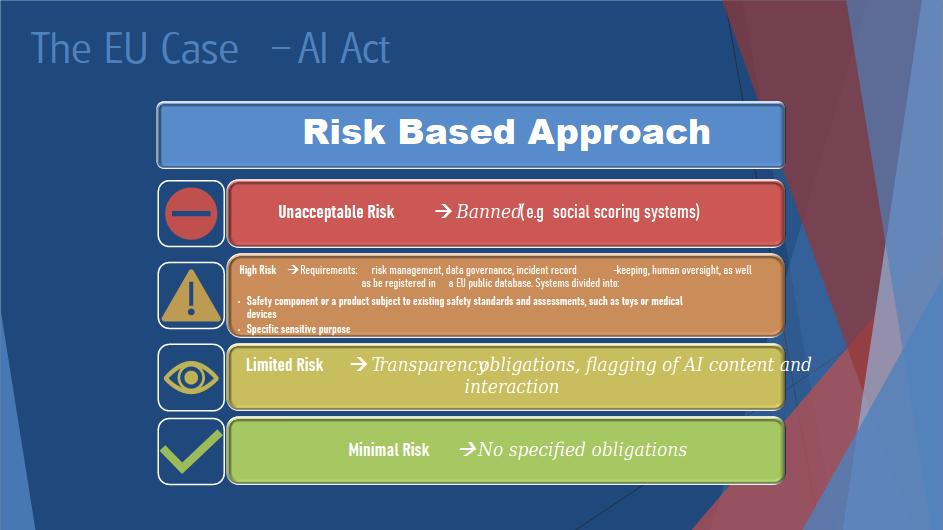

Tanto no caso da IA «fraca», que agrega dados pré-existentes (v.g. ChatGPT), sendo geradora não consciente de conteúdos, como no caso dos programas de IA «forte», capazes de sintetizar intencionalmente conteúdos, proceder a deduções e, no limite, ganhar consciência (super-inteligente ou não), todo o debate decorre dentro do horizonte de sentido do Risco e não da Incerteza (a computação quântica é desenvolvida dentro dos modelos computacionais clássicos mas isso é concebido como algo temporário; já a subsunção da Incerteza em Risco é um problema de método com implicações inatendidas). O recente primeiro documento regulador da IA (aprovado pela UE em Dezembro de 2023 e confirmado em Março de 2024), concebe todo o processo regulatório em base de riscos (4 categorias) – embora não as quantifique, sendo um caso não assumido de «risco subjectivo» que pretende valer objectivamente e mesmo normativamente (apesar de este último passo ser improvável dada a natureza deslocalizada de muitos dos processos envolvidos e as divergências em matéria regulatória com outras potências, mesmo as mais próximas, como no caso do EUA).

Dada a sua natureza única e o seu estado de aplicação ainda incipiente, não é o facto isolado de haver uma regulação europeia que nos interessa, mas sim o modo como esse documento foi pensado. O investigador italiano Francesco Ancona (Milão) sintetiza bem a centralidade do Risco na concepção do quadro regulatório europeu no seguinte passo da sua apresentação realizada em congresso de 2023:

De: Francesco Ancona (com autorização do Autor; inédito, Ancona 2023)

MA International Relations – Università degli Studi di Milano.

Cumpre notar a ironia de um conceito que pretende sinalizar a não-certeza (se não se quer usar Incerteza), para a qual é necessário obter algum «seguro», seja cada vez mais empregue de modo determinista, como se não lhe fosse intrínseco a falibilidade. Esta apodicticidade forçada gera paradoxos como o de «risco inaceitável» (não definido, apenas ilustrado, et pour cause). Que não haja, nem possa ser criada num futuro previsível, uma amostra fiável para determinar risco no campo da IA é simplesmente ignorado; a «análise baseada no Risco» é o mantra que se veicula para inspirar confiança.

Para o nosso fito, queremos contudo salientar neste momento dois pontos de natureza política, que merecem ser considerados na supervisão e legislação de questões tecnológicas (IA ou não), sobrepondo-se mesmo (ao menos metodologicamente) a considerandos de natureza económica:

1) O modelo de regulação da IA europeu, aprovado com grande publicidade em 20239 (mas ainda não implementado10), estrutura-se na linguagem de Risco tal como o dos seus aliados, em especial os EUA. Mas apesar desta afinidade cultural e procedimental, vale a pena notar que os próprios EUA têm uma visão abertamente crítica das opções da UE por as considerarem limitativas à inovação11. Esta divergência tem causa económica (dinamismo da actividade nesta área é muito superior nos EUA do que na UE), mas tem implicações geopolíticas – os EUA defendem os valores ocidentais nos seus termos, não há homogeneidade com o modelo europeu;

2) Além deste diferendo ainda amigável dentro do espaço Ocidental que importa ter presente, urge sublinhar que é um erro de cálculo supor que outros blocos políticos (e culturais) estão inclinados a adoptar ou sequer a adaptar-se ao espírito das leis europeias; tal como noutros domínios, desde a esfera Ambiental até à Segurança e Defesa, aquilo a que se assiste no campo dos regimes iliberais (Rússia, China, Irão, etc.) é a movimentos diametralmente opostos e sistematicamente desenvolvidos contra as práticas que ocidentais (maxime europeus) tomam como boas; seria mais grave do que um crime, seria um erro grosseiro supor que essa realidade se irá alterar, pelo que importa reconhecer o carácter defensivo da normatividade europeia nesta matéria – sem indústria de monta, a defesa dos valores que promove é a defesa da sua situação, reconhecidamente frágil.

Destas duas premissas não deriva, em nosso entender, nenhuma necessidade de mudança de estratégia. Mesmo a diferença face a EUA pode ser compatibilizada e reproduzir, no campo da IA, uma assimetria entre os dois lados do Atlântico que não impede a sua cooperação (como já se verifica no campo dos satélites).

Sobre esta situação sublinhamos:

a) as suas implicações são de natureza tecnológica, mas de implicações económicas gerais, não se limitando a aspectos de Defesa e de Segurança;

b) ser pertinente um modelo analítico menos linear que a habitual simples distinção entre regimes que usam tecnologia com ou sem respeito pelos Direitos Humanos.

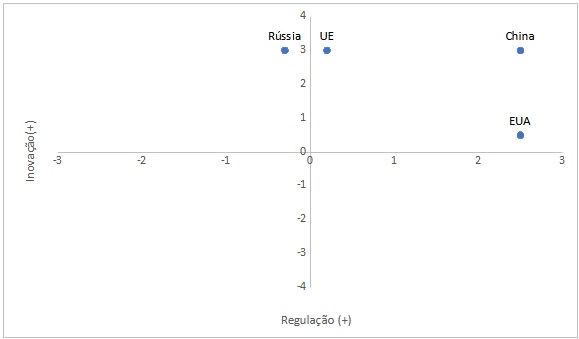

Este modelo pode ser apresentado como um «compasso IA» (parafraseando o sucesso do political compass). Um eixo horizontal diferencia grau de inovação; um eixo vertical faz o mesmo para o grau de regulação dessa inovação. Note-se que se verifica uma coincidência para resultados relativos a IA e para actividade económica em geral. Assim, teremos:

Naturalmente, esta apresentação esquemática é muito sumária. Ela reduz-se à posição dos agentes estatais (incluindo neste UE por coerência de exposição) face ao progresso da IA, de modo a distingui-los, sem dar conta do progresso cujo driver é o sector privado. Esta outra realidade, contudo, excluiria de uma comparação homogénea a Rússia e a China, mas a especificação do modelo segundo sucessivas diretrizes será útil12.

Relevante é que aqui se propõe uma diferenciação feita não em termos de Risco mas de Incerteza, isto é, qualitativa e não quantitativa. Esta abordagem é duplamente importante, pois diferencia aquilo que o risco homogeneíza, pela sua natureza quantificada (a atitude face a inovação), e ainda permite estabelecer um quadro interpretativo, e aperfeiçoável, numa área sobre a qual a informação tende a ser escassa e insegura, pela sua novidade e pelo seu carácter confidencial.

Concordamos por isso com Osório de Barros quando este afirma: «A UE deve desempenhar um papel central no futuro do mercado global de IA. A região destaca-se pelo foco em IA ética, na disponibilidade de qualificações especializadas (reserva de talento em IA, com elevado número de programas de mestrado especializados e contribuição para 16% dos artigos de investigação globais nesta matéria) e na realização de iniciativas de I&D.» (Osório de Barros, 2023: 6). Esta descrição, matizada pela ligação da UE aos EUA e pelas diferenças de perspectiva a este respeito que já notámos, coloca os europeus numa posição ancilar aos americanos, precisamente pelas limitações auto-impostas. Assim, também as afirmações do mesmo autor especificamente sobre o papel para a economia portuguesa da introdução da IA merecem concordância com qualificações: o foco na cooperação internacional (idem, p. 7 e p. 9) envolve directamente os EUA, de onde provém a maior parte da inovação acessível no Ocidente em IA, os quais já vimos se regerem por um entendimento diverso do que significam os riscos associados a IA; e o foco (pp. 7/8) no desenvolvimento da economia portuguesa através de recursos de IA (concebida no paradigma ético da regulação da UE) pressupõe mecanismos de Segurança e Defesa que nem aí se encontram vertidos nem são garantidos pelo enquadramento no bloco europeu.

Em suma, a modernização económica na qual a IA é decisiva revela-se instrumental na promoção de um conjunto de valores, verificando-se aqui coincidência entre Portugal e UE (e alguma proximidade face a EUA). Contudo, na competição global no desenvolvimento da IA, competição na qual outros estados líderes na investigação (China) e no emprego (China e Rússia) da IA se regem por outros valores (iliberais) e outros fins (promoção de uma ordem internacional alternativa ao sistema ONU), as opções europeias (e portuguesas) ficam reféns de estratégias geopolíticas que não as suas e de apoios que apenas podem solicitar (mesmo tendo em conta a existência de tratados e organizações europeias-americanas). Divergimos, assim, de Osório de Barros quando este conclui que «a ascensão da IA representou uma mudança de paradigma a nível mundial» (idem, p. 9) – não havia um só paradigma antes (vide o uso de WWW e de apps em regimes iliberais) e não haverá agora, pois o desenvolvimento da IA aumenta a tensão entre os agentes, como se verifica em sucessivos actos eleitorais em democracias ocidentais visados por ciberataques e por várias campanhas de desinformação13. Em rigor, e este é um ponto decisivo em favor da adopção mais frequente de estimativas de Incerteza, o próprio modelo de análise de Risco obsta a um tal paradigma único: além das diferenças de grau entre EUA e UE já mencionadas, há diferenças estratégicas face a outros actores14.

A economia portuguesa, devemos ter presente, sofre nesta matéria de limitações e problemas que prolongam os do passado: os seus quadros jovens e qualificados tendem a sair do país também neste campo; a falta de capital dificulta o scale up de empresas tecnológicas; a exuberância legislativa e fiscal portuguesas (que se somam ao quadro europeu); baixa produtividade; a opacidade induzida institucionalmente de forma generalizada; tudo convida a sediar projectos noutras paragens. Nada nisto é novo, sendo que, infelizmente, nada indica que esteja no horizonte qualquer mudança significativa, a avaliar pelo debate público em curso à data em que escrevemos (em Março de 2024, algum candidato a legislador e governante se exprimiu sobre IA, p. ex.?). Donde, partilhando genericamente a identificação de possibilidades que a IA abre à economia portuguesa feita por Osório de Barros, não antevemos que a sua prossecução possa conduzir a uma mudança estrutural (à falta de melhor termo) dos tradicionais entraves ao desenvolvimento económico do país.

Devemos inclusivamente notar como o entusiasmo de há três décadas com a digitalização da economia (quase sempre desenvolvida no âmbito do sector público) não logrou operar a transformação esperada, o «salto qualitativo» nas qualificações, pelo que colocar agora a mesma fé nas capacidades da IA para ‘alavancar’ (por uma vez um uso adequado a este termo infeliz) a modernização económica e até social (se levamos a sério o foco dado à ética), será no mínimo voluntarismo. Importa formatar as expectativas de aplicação económica de IA em consonância com os factos:

– Sem capital acessível para fazer o scale-up, as start-ups vão seguir o rumo dos jovens qualificados e emigrar;

– Sem normas de transparência eficazes e desburocratização, a perpetuação dos mesmos agentes (com resultados não muito diversos) será a regra;

– Sem uma política combinada (UE e NATO, pelo menos) de integração da indústria tecnológica em bloco(s) de âmbito geopolítico, os efeitos transformativos da IA serão sempre diminuídos e dispersos, insuficientes face a competição global;

– Prioridade nacional e europeia deve, portanto, incidir nas tecnologias de duplo uso em áreas críticas, de bens públicos: Energia e gestão do território; transportes e comunicações, Segurança e Defesa, Saúde e alimentação (sem estas prioridades, a salvaguarda da resiliência das cadeias de abastecimento, consensual desde a pandemia de covid19, é inviável).

Nada disto diminui o papel do Estado, tanto na fiscalidade como na administração da Justiça, na educação ou na condução da política externa. O foco nas áreas elencadas acima visa, sim, limitar expectativas e conter a crescente desilusão com a democracia15 resultante de expectativas impossíveis de cumprir e de sucessivas escusas de responsabilidade. Esta tendência deslegitimizadora é real e coloca em causa a própria viabilidade do quadro regional de Portugal, a UE. Particularmente sensível é o inevitável impacto que o desenvolvimento acelerado de IA e tecnologia relacionada (bases de dados) tem no aumento de consumo de eletricidade, tornando o objectivo da transição para fontes renováveis mais distante, e também no consumo de água para efeitos de arrefecimento do equipamento (um analista como Alex de Vries tem estudado estes temas quer nas criptomoedas quer na IA, e concorde-se ou não com as suas posições o problema é pertinente); aliás, é nossa convicção que se devia procurar estabelecer uma correlação o mais sistemática possível do uso de energia e do uso de água, sobretudo potável – o que fica aqui registado apenas como sugestão para um próximo tema a explorar na perspectiva de Segurança&Defesa. O foco da introdução da IA em áreas específicas da actividade propicia a obtenção de resultados económicos e contribui para contrariar aquela tendência sociopolítica de des-democratização voluntária (ou de anomia prolongada, ainda outro problema).

Neste contexto, há que atender ao facto de estar a começar a entrar no mercado de trabalho a primeira geração que viveu sempre sob o Google, «no» Google, para a qual as possibilidades tecnológicas naturalmente se devem realizar, para a qual a reversibilidade da realidade é presumida e a hierarquia é noção vetusta. Há que avaliar a distância que a separa face aos líderes (de opinião, de indústria, de política) que se formaram num momento histórico anterior e que, por isso, pedem a suspensão dos avanços da IA como se isso fizesse sentido, indiferentes ao mundo que já criaram, no qual é «a» realidade que devém uma noção a caminho de se tornar obsoleta. Sem uma «deep reality» para contrariar «deep fakes», toda a experiência tecnológica, cada vez mais sinónima da experiência social, se reduz gradualmente a trânsito de bits, maxime imagens. A expressão celebrizada há poucos anos com grande escândalo «alternative facts» exprimia isto mesmo de um modo ainda pueril: na realidade tecnológica, anulam-se factos e multiplicam-se alternativas. Para conduzir a transformação tecnológica de sociedade e economia, ou a ética da IA é parte de uma praxis como a esquematizada nos quatro itens acima ou resume-se a ser uma prece a um deus, venerando mas distante16.

Se, como argumentámos, a relevância da IA na modernização da economia portuguesa decorre dentro de um quadro europeu (UE) que necessariamente reporta a um quadro global de complexidade crescente, é fundamental dispor de modelos de análise e interpretação destes processos que os esclareçam sem os simplificar, mesmo quando isso signifique admitir que não dispomos do conhecimento de que necessitamos e nos movemos em condições de Incerteza.

Para tanto há que reconhecer que as análises de Risco, segundo a díade custo/benefício, redundam por regra em justificações para que se incorra em riscos em questão; mais relevante ainda, e notória no caso das questões de tecnologia, é a aversão a sequer considerarem que exista algum limite (pré-dado ou auto-imposto) à instalação da tecnologia na existência humana, aliás, na existência planetária (e mesmo orbital17). A temática do pós-humano, e o advento da «singularidade», radicam aqui, tal como o entusiasmo com o potencial paradigmático da IA. Tudo decorre como se a combinatória risco/tecnologia fosse uma necessidade inquestionável. Mesmo as suas consequências indesejáveis e combatidas, p.ex., nas mudanças climáticas, são abordadas na perspectiva do «tech fix». Muitos destes exercícios são desenvolvidos no «eterno presente» da vida moderna e de muita da sua ciência social, dependendo de forma inelutável de transferências de risco (de consequências) para o futuro (poluição, dívida, etc). Consequência directa e forçosa desta conflação da vida com a tecnologia, a mediação entre ambas (o pensamento científico) é já subsumido na própria tecnologia, cujos produtos consubstanciam a Ciência de direito e de facto (a preponderância actual no ensino das áreas cientifica-tecnológica-engenharia-medicina, ditas STEM, evidencia este processo, «tool-driven»). Assim, para a simbiose entre tecnologia e experiência humana que a cada dia progride mais aberta e intencionalmente18, a linguagem do Risco (na qual os riscos são sempre aceitáveis) serve de língua franca, sem as tensões, restrições e matizes associadas à Incerteza.

O Risco enquanto conceito franqueia todos os riscos praticáveis na nossa normalidade científica e social. Seria bom, então, complementar o seu uso com o de Incerteza, conceito seu derivado e cada vez mais alinhado com as condições de trabalho em áreas estruturantes do desenvolvimento tecnológico em geral (IA e igualmente correlatos) nas quais escasseiam dados essenciais, falta não por falta de capacidade de processamento, mas por esses dados ainda estarem a ser criados. Na economia como em outras áreas19, as consequências são significativas.

Ancona, F., «The role of Generative AI in spreading disinformation: current uses and possible applications in the civil and military domain», comunicação à conferência “Digital Revolution and Artificial Intelligence as Challenges for Modern Societies”, University of Bielsko-Bialski – 17 November 2023 (inédito).

Cihon, P. (2019), Standards for AI Governance: International Standards to Enable Global Coordination in AI Research & Development – Technical Report, Oxford: https://www.fhi.ox.ac.uk/wp-content/uploads/Standards_-FHI-Technical-Report.pdf

Kay, John e King, M. (2020) Radical Uncertainty, Bridge Street Press, London.

Leone, C. (2020), Normalidade, Theya, Lisboa.

Martins, H. (2011), Experimentum Humanum, Relógio d’Água, Lisboa.

Martins, H. (2012), «Empresas, Mercados, Tecnologia – uma perspectiva biográfica», in NADA, http://www.nada.com.pt/?p=artigos&a=va&ida=45&l=pt

Martins, H. (2012a), «Em casa de Hermínio Martins, in NADA, https://www.nada.com.pt/?p=artigos&a=va&ida=40&l=pt&fbclid=IwAR21D5TpuPbvnXAKUDVYIacflBcbr8kt8b9bLsZWMpEQ55tAExLvviPVRU0

Osório de Barros, G. (2023) «Portugal e a Inteligência Artificial no Contexto da União Europeia», comunicação ao Congresso Nacional da Ordem dos Economistas, Sessão 3: Inteligência Artificial (Setembro de 2023).

Redlicki, B. (2017) «Spreading Lies», Cambridge Working Papers in Economics, CWPE1747 doi: 10.17863/CAM.15509.

Sakay, Y. (2019) J.M. Keynes Versus F.H. Knight: Risk, Probability, and Uncertainty, Springer.

Sastry, G, et al. (2024) «Computing Power and the Governance of Artificial Intelligence», Cambridge: https://www.cser.ac.uk/media/uploads/files/Computing-Power-and-the-Governance-of-AI.pdf

Wolf, M. (2023) A crise do capitalismo democrático, Gradiva, Lisboa.

Zwetsloot, Remco and Allen Dafoe (2019) «Thinking About Risks From AI: Accidents, Misuse and Structure» in Lawfare: https://www.lawfaremedia.org/article/thinking-about-risks-ai-accidents-misuse-and-structure

O autor agradece a Francesco Ancona a disponibilização para reprodução de parte da sua comunicação (Ancona 2023), ainda inédita.

____________________________

* Este título é tributário de «Risco, Incerteza e Escatologia», artigo publicado em duas partes no final da década de 1990 na revista EPISTEME pelo sociólogo português radicado em Oxford Herminio Martins (1934-2015), entretanto republicado em Martins 2011 (pp. 173-231, de onde citamos aqui).

1 Percebe-se assim como o big data de hoje se presta a prosseguir nesta via, sem cuidar de outros elementos, num processo automático.

2 Mais rigorosamente, dever-se-ia falar de sublevação contra a regulação. Toda a «shadow banking» de NBFI (non-bank financial intermediaries ) foi um constructo intencional elaborado contra a ideia (e prática) regulatória. Não uma alternativa, pois encontrava-se ligado à banca em sentido próprio – como a crise de 2007 evidenciou – e toda a sua extraordinária dimensão dependia dessa ligação, arquitetada para lá da regulação do sector financeiro.

3 Regressaremos a este ponto mais tarde a propósito do conceito de Incerteza, mas é apropriado observar que foi esta disparidade que levou ao sucesso de noção como «too big to fail», como quick fix. É uma mentalidade própria de «economia de casino» ou de capitalismo de casino, como descrito nos anos 1980, por Susan Strange.

4 Ou seja, o Risco é produto de um estádio avançado de capitalismo, no qual se encontra já uma acumulação de riqueza relevante e uma sua distribuição bem estratificada. Poder-se-á definir assim o Risco como modo normal de regulação na sociedade capitalista moderna e contemporânea, sendo a Incerteza pertinente nas suas situações-limite: no período de acumulação primitiva de riqueza (para utilizar este termo de cariz marxista num sentido próximo do uso que Knight dá à Incerteza na sua obra de 1921) e nos casos que escapam ao modo normal da actividade económica tardo-moderna (por vezes a anulam). Será neste último caso que a questão específica da IA se coloca. Outra questão, ainda impossível de determinar, é se a atitude face à tecnologia em geral mantém o padrão tardo-moderno (individualista) face à riqueza (e ao seu objecto, o dinheiro), estudado por Simmel em 1900 (A Filosofia do Dinheiro). Pode dar-se o caso, concomitante, de a IA ser mais uma ferramenta propiciatória da massificação já em curso das práticas de consumo conspícuo que Veblen descreveu em A Teoria da Classe Ociosa (um ano antes da obra de Simmel), desta feita no domínio específico dos bens tecnológicos.

5 Existem excepções, como o Center for the Study of Existencial Risk (University of Cambridge), cf. https://www.cser.ac.uk/. E numa perspectiva ainda mais ampla, o Institute for the Future of Humanity (University of Oxford), de onde emanou em 2019 um «technical report» sobre padrões internacionais de governança da IA que merece hoje ser revisitado, ver Cihon, 2019 (de cujo voluntarismo não nos encontramos próximos). Do ponto de vista legal, também já desde a última década este é um dos temas de debate, cf. Zwetsloot e Dafoe, 2019 (o foco deste texto em Risco não constitui problema, pois o seu escopo «estrutural» comporta o plano de incerteza que aqui abordamos). O ponto da Zwetsloot e Dafoe sobre a importância da perspectiva histórica deve ser notado em particular, reforçando o Technical Report do Institute for the Future of Humanity, que reconhece como os padrões nacionais permanecem relevantes (cf. p. 21). O global não dispensa o local, tal como o futuro não abole o passado.

6 Kay, John and Mervin King (2020), um dos autores presidiu ao Bank of England. Mantemos o original, apenas editando ligeiramente.

7 A própria diferenciação entre terceira e quarta revolução é discutível, atendendo a que têm em comum o driver tecnológico (digital), ambas expandem a conectividade (WWW, telefones celulares), e dependem sempre de aumento de energia disponível (coincidindo também na demanda por energias limpas e pela descarbonização da economia). Como a mudança de grau na conectividade que permite pensar em termos de Internet das Coisas pode ser considerada qualitativa e não apenas uma quantidade do que já se verificava no mundo da terceira revolução industrial, seguimos essa leitura, pois é nela que a relevância da IA (e outros processos, como computação quântica) melhor se evidencia, tanto conceptualmente como economicamente.

8 Para uma análise mais longa e dedicada de um caso específico, o da pandemia COVID19 e resposta a ela, cf. Leone 2020.

9 https://www.politico.eu/article/eu-strikes-tentative-deal-ai-act-artificial-intelligence/?utm_source=email&utm_medium=alert&utm_campaign=EU%20negotiators%20strike%20political%20

deal%20on%20AI%20Act

10 Nisto, Portugal está na vanguarda europeia, com muita da sua produção normativa (v.g. sobre cibersegurança) longe de estar efectivamente implementada.

11 Na mais recente conferência anual da Câmara de Comércio Americana (AMCHAM), realizada na Faculdade de Farmácia (UL), a 11/10/23, o «deputy» do Economic Sector da Embaixada dos EUA em Lisboa, Nick Parikh, focou na sua intervenção (oficial, não em nome pessoal) a regulação da IA, nomeadamente na definição de «risco» empregue pelos europeus, que descreveu como sendo uma «trade barrier». Disse ainda expressamente que a regulação da UE não permite flexibilidade ao desenvolvimento tecnológico. Esta mensagem oficial dos EUA à UE é tanto mais significativa quanto os EUA inovam muito mais do que a UE neste domínio e são o único contrapeso global ao avanço chinês (e de outros poderes não ocidentais) neste campo. As sucessivas multas da Comissão Europeia a tecnológicas americanas reforçam a tese da «trade barrier».

12 O processo judicial em curso de Elon Musk contra a ChatGPT tem por isso interesse intrínseco, pela relevância dos envolvidos, e relevância estratégica, pelo estatuto particular que a sua natureza de iniciativa privada de alcance global lhes confere: estatuem-se como agentes ao nível de Estados em questões de geopolítica clássica como a Guerra em pontos decisivos (IA, satélites, www). Reportamo-nos aos dados disponíveis em Março de 2024. (https://www.publico.pt/2024/03/02/tecnologia/noticia/elon-musk-processa-openai-abandonar-propositoinicial-2082285?ref=hp&cx=bloco_cat_10 ). Ainda em Março de 2024, o mesmo Musk decidiu avançar com GROK, uma IA concorrente do ChatGPT, diferenciando-se (alegadamente) pela sua «personalidade» própria, descrita em termos do debate cultural e político americano das última décadas (culture wars) como sendo «anti-woke» (https://grok.x.ai). Este ponto não deve ser menorizado: tal como existe de facto e de direito, institucionalizado, um desencontro entre EUA e UE neste campo, também no interior das sociedades ocidentais se manifesta uma confrontação cada vez mais aberta e – sobretudo – mais radicalizada em termos culturais (e que não foi iniciada pelas redes sociais hoje demonizadas). Dada a sua natureza mimética, a IA não tem como se eximir a esta conflitualidade interna e aos seus paradoxos. Outros casos interessantes para acompanhar os usos polifacetados da IA são o que envolvem o uso da IA Nightshade (https://nightshade.cs.uchicago.edu/whatis.html) e casos de «artesanato IA» com implicações de monta (https://observador.pt/2024/03/07/argentino-cria-dispositivo-com-inteligencia-artificial-que-ataca-colunas-quando-toca-reggaeton/, acedido a 07/03/24).

13 Para um modelo interpretativo económico, mas plástico, cf Redlicki, B. (2017).

14 Retomamos aqui a discussão das n. 6, 12, 13 e 14: tal como na produção industrial a adesão da China (e Índia, acrescente-se) à OMC bastou para resolver os problemas de violação de direitos de autor, também na IA esse padrão nacional não deve ser entendido como uma imperfeição, mas como uma estratégia (a implementação de «créditos sociais» comprova-o). Os riscos são diferentes e as incertezas também; a agência é concebida de modo não apenas diferente mas em alguns casos adversarial. E, como lembra o Technical Report já em 2019 (cf. p 22), «Insofar as these national strategies seek to develop AI national champions and given the network effects inherent in AI industry, AI nationalism is of transnational ambition.» (Sem surpresa, o report imediatamente considera a questão do 5G, cf.p. 23). Ora, a dimensão nacional condiciona a Defesa na UE de um modo muito mais limitativo do que nos casos de Rússia, China e EUA (países-bloco). E, dentro da União, países com base industrial diminuta, como Portugal, ficam em situação particularmente frágil (sobretudo se descapitalizados, como é o caso).

15 Cf Wolf 2023, espec. Parte III.

16 O modelo de trabalho a desenvolver pode, a nosso ver, ser o seguido por Sastry, G., et al, 2024 (para focar em IA, mas servindo de norma para tecnologia em geral). Parte-se de um dado (não postulado) concreto: «The central thesis of this paper is that governing AI compute can play an important role in the governance of AI. Other inputs and outputs of AI development (data, algorithms, and trained models) are easily shareable, non-rivalrous intangible goods, making them inherently difficult to control; in contrast, AI computing hardware is tangible and produced using an extremely concentrated supply chain.» (p. 2; cf. pp. 2/3 para matizar tese geral). Toda a análise é desenvolvida dentro da praxis em vigor. O facto de o documento aderir à linguagem do risco não diminui a sua relevância nem contradita o argumento que aqui desenvolvemos (incerteza como subcampo de Risco); representa ainda o estado da arte na reflexão sobre regulação no campo da IA, numa perspectiva primordialmente teórica (cf., no entanto, os Anexos A e B do texto, este último um valioso elenco de casos de Incerteza). Dado ser trabalho recente, coincidente com a redação deste texto, não podemos aprofundar aqui os seus dados.

17 As recentes controvérsias (já de 2024) sobre a nuclearização do espaço prolongam ensaios na década anterior de constituição de forças militares espaciais e somam-se ao problema já há muito conhecido da proliferação de lixo em órbita (e que continua a crescer, apesar de conhecido).

18 Para uma abordagem autodesignada biográfica a esta reificação tecnológica da vida, merece releitura o ensaio de Hermínio Martins «Empresas, Mercados, Tecnologia – uma perspectiva biográfica», (Martins, 2012) surgido na revista NADA: http://www.nada.com.pt/?p=artigos&a=va&ida=45&l=pt (acedido a 3/3/24). Ver também a entrevista que originou o ensaio: «Em casa de Hermínio Martins» (Martins, 2012a).

19 Veja-se o caso dos fundos marinhos, ainda menos mapeados do que o espaço sideral, que agora conhecem a sua tecnologização acelerada (e de novo com divergências consideráveis mesmo dentro dos blocos geopolíticos referidos, com a França a opor-se ao deep sea mining), imbricada em questões geoestratégicas de primeira ordem (v.g. https://www.hgc.com.hk/press-releases/statement-supplementary-information-of-hgc-global-communications-regarding-submarine-cable-damage-in-the-red-sea-to-demonstrate-hong-kong-as-international-telecommunication-hub-to-demonstrate-hong-kong-as-international-telecommunication-hub), tema que em Portugal começa a ser aprofundado depois de anos de entusiasmo ingénuo com a amarração de cabos submarinos concebida apenas como fonte de receita (problemática em que dispomos já de uma instituição com trabalho e experiência consolidada no ministério da Defesa, o Centro do Atlântico). Os fundos marinhos são talvez o caso exemplar de uma necessária autonomia estratégica portuguesa, pois da competência neste domínio depende o sucesso da proposta à ONU da extensão da plataforma continental portuguesa – questão de soberania pura.

Licenciado em Filosofia (1996) e doutorado em História das Ideias (2004), pela UNL-FCSH.